2月6日早盘,市场迎来大幅回调,但人工智能AIGC持续火爆。

在前两天的文章中,我们曾提到算力或是人工智能当前最大的瓶颈(爆火的AIGC当前最大瓶颈或是它)。而国盛证券在最新研报又重点分析了算力和光通信的关系,其认为细分CPO(光电共封装技术)有望成为高算力下解决方案,CPO配套硅光可能在未来2-3年有望快速放量。

兴业证券也指出,AIGC算力狂飙,光模块等云计算基础设施配置价值凸显。

算力爆发推升数据传输需求

数据显示,自2012年至2018年,用于训练AI所需要的算力大约每隔3~4个月翻倍,整体呈现指数级上涨(而摩尔定律仅仅是18个月翻一倍)。从2012年到2018年,训练AI所耗费的算力增长了30万倍,而摩尔定律在相同时间只有7倍的增长。

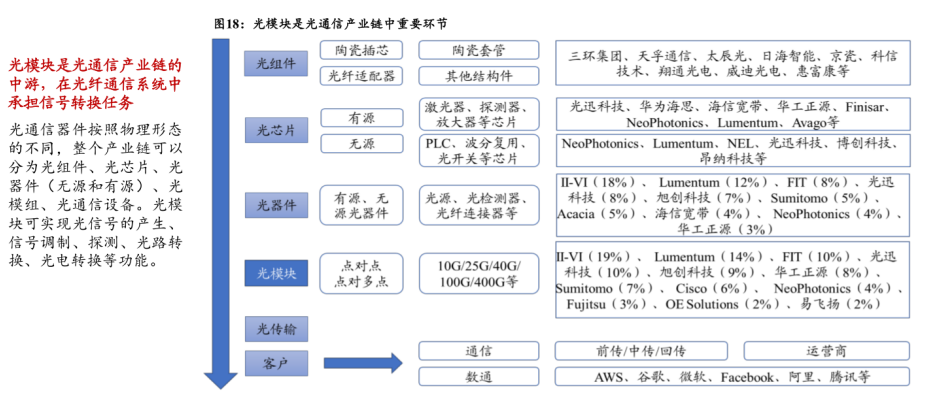

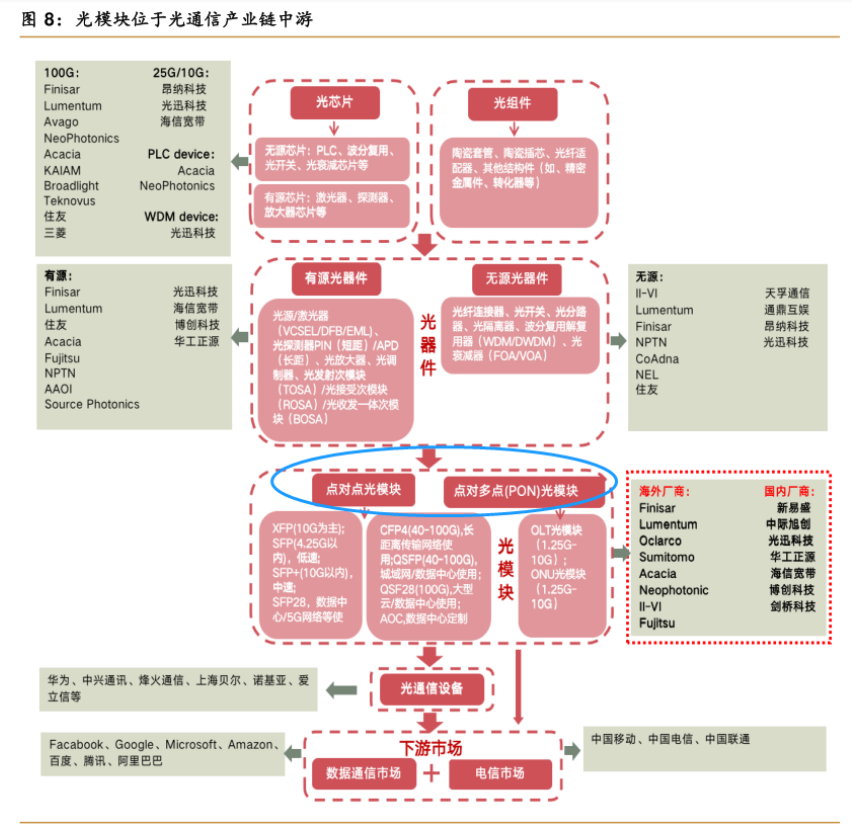

据国盛证券研报,基于AI的高算力场景,基础设施包括硬件设备相关最明显的一个变化是算力大幅增长后,相关能耗和成本也会大幅提升。而光模块是数据中心、光通信网络等信息基础设施实现数据传输的基础必需单元。

据中国通信网,算力作为数字经济核心生产力的重要构成,其关键能力释放离不开通信网络的有效支撑,光通信网络作为信息基础设施重要组成和关键承载底座,承担着“信息高速公路”和“信息高铁”的角色。

其指出,随着产业数字化转型不断深入,算力应用需求呈现出超大带宽、低时延、灵活连接、低能耗等特征,光通信网络将聚焦超大容量传输、全光组网、开放自智、光子集成等热点技术革新发展,协同增强网络运力,助力数字经济加速发展。

CPO的低功耗或成为AI高算力下高能效比方案

简单介绍一下CPO(光电共封装技术),随着5G时代高带宽的计算、传输、存储的要求,以及硅光技术的成熟,板上和板间也进入了光互连时代,通道数也大幅增加,封装上要将光芯片或光模块与ASIC控制芯片封装在一起,以提高互连密度,从而提出了光电共封装的相关概念。

据国盛证券研报,基于AI的高算力场景,基础设施包括硬件设备相关最明显的一个变化是算力大幅增长后,相关能耗和成本也会大幅提升,而当前方案可能无法满足(速率升级或堆叠的方式),所以整个设备一大变化就是低功耗低成本高能效解决方案。

这样的背景下,国盛证券指出,CPO(光电共封装技术)的低功耗或成为AI高算力下高能效比方案。

1)功耗:通过设备(交换机等)和光模块等耦合在背板PCB上,通过液冷板降温,降低功耗。

2)体积/传输质量:满足超高算力后光模块数量过载等问题。同时将光引擎移至交换芯片附近,降低传输距离,提高高速电信号传输质量。

3)成本:耦合之后未来伴随规模上量,成本或有一定经济性。

国盛证券表示,高算力场景下,交换机/光模块等设备和器件,基于功耗和成本等考虑,可能会发生结构性的变化,通过新技术、CPO(光电共封装)、硅光、耦合、液冷散热等共同达到“高算力但非高功耗”的目标。其认为,ChatGPT加速的AI的进程,对于功耗和成本的要求来得更快,CPO配套硅光可能在未来2-3年有望快速放量。

据Lightcounting预测,CPO出货量预计将从800G和1.6T端口开始,于2024至2025年开始商用,2026至2027年开始规模上量,主要应用于超大型云服务商的数通短距场景。

国内光模块供应商“独领风骚”

据C114报道,日前LightCounting在一份市场报告中指出,过去的十年里,中国的光器件和模块供应商逐渐在全球市场上获得份额。另外,在FTTx和无线前传等较小的细分市场,几乎都是中国供应商。

锐捷发布首款CPO交换机 硅光+液冷引领下一代数据中心风向

作为光子集成的未来发展方向之一,硅光技术越来越受到行业上下游的认可,国内外头部厂商都在硅光技术路线上不断“加码”,与CPO(Co-Packaged Optics)光电共封装技术相关的公告和标准不断涌现。近日,锐捷网络正式推出了首款应用CPO技术的数据中心交换机,为CPO市场“拉开帷幕”。

CPO元年已至 锐捷首款CPO交换机火热“出炉”

被业界火热讨论的硅光技术,是光子技术的一个前沿发展方向,即利用硅光的低成本、高速特性的光通信技术。目前,硅光技术有两个发展路线:CPO(Co-Packaged Optics)光电共封装和NPO(Near Packaged Optics)光电近封装,两种方案均能够在带来数据中心性能提升的同时,显著降低能耗。而拥有更高集成度的CPO则迎来了自己的“元年”。据CIR机构的推测,CPO数据中心设备市场将于2022年正式起步,并且迎来快速发展期。CIR给出的数据中心CPO设备市场发展预测

近日,锐捷网络正式推出了首款应用了CPO技术的数据中心交换机。整机交换容量为25.6Tbps,2RU的机箱高度,支持32x400G QSFP112可插拔光模块接口和16x800G MPO16光接口。

算力提升与绿色节能的矛盾

为什么是硅光?为什么是锐捷?一切的源头,都要回到数据中心的两个重要发展因素——算力和能耗。

随着“新基建”“东数西算”以及十四五等建设目标的不断落地,数据中心建设正在大踏步向前,然而随着流量高规模增长和带宽持续提升,带来了前所未有的能耗问题。

据统计,2021年全国数据中心总用电量2166亿千瓦时,占全国总用电量的2.6%,相当于2个三峡水电站的年发电量。未来新建的数据中心正向着超大规模集群的方向发展,预计在明年总用电量将突破2500亿千瓦时,2030年用电量比达到全国的3.7%。

在“双碳”政策背景下,近日,工业和信息化部等七部门发布《信息通信行业绿色低碳发展行动计划(2022-2025年)》,建设集约绿色的超大规模数据中心成为大势所趋,同时最新的国标要求到2025年,新建大型、超大型数据中心电能利用效率(PUE)降到1.3以下。

《数据中心能效限定值及能效等级》

作为耗电大户的数据中心,算力提升与绿色集约成为相辅相成的发展因素。

平衡高性能与低功耗 打破物理瓶颈的硅光

距离的问题,靠近距离来打破。

面对AI、ML和高性能计算(HPC)对于网络带宽提升的需求,短短十几年间光模块的单端口速率从千兆(1G)增长到800G,配套光模块速率增长了800倍,功耗则增长了30倍。而高速高密度互联传输场景下需求仍在提升,无论是硬件的性能极限,还是光模块散热对于端口密度的制约,业界都在期盼一种可代替传统光模块的新型光产品或技术,来解决性能提升与能耗之间的平衡难题。

用NPO+液冷翻过“散热”的山 锐捷网络始终“快”人一步

1度电只有一半用在了计算上,其他的则在散热、照明上。

面对数据中心的能耗“焦虑”,除了在硅光技术上大幅投入,锐捷网络也着重发力在数据中心散热的液冷技术的创新研究。

目前,我国整体数据中心PUE平均水平在1.8左右,传统风冷数据中心则在处于1.5-2.0之间,想要按照新国标的要求降低到1.3,甚至是1.25以下,风冷受到散热器热阻和尺寸限制,已经很难满足未来数据中心散热需求,而使用更高比热容和导热效率的液冷,成为了技术突破的方向。

使用冷板式液冷技术,以导热效率更高的液体作为冷媒,相比风冷能够在更小的体积下带来更高的散热效率和更低的PUE,而且去掉了风扇,降低了设备的噪音。

截至目前,锐捷网络已正式发布了多款同时应用硅光技术和液冷技术的交换机,其中,两款设备都采用了硅光NPO+冷板式液冷的设计,在1U的高度内集成了高密度的800G端口,却比传统风冷设备拥有更高的散热效率,更低的能耗,给客户提供了多种液冷产品和技术方案的选择,有效助力绿色数据中心的建设。

锐捷在OFC22上发布的51.2T硅光NPO冷板式液冷交换机

数据中心已经逐渐成为了数字经济中的重要纽带,算力提升与绿色节能将成为数据中心发展的长期主题。而作为行业领先的ICT基础设施及行业解决方案提供商,锐捷网络也会将自身在技术能力、场景创新、产品研发上的优势,转化为助推数据中心向高性能、低能耗的绿色、智能、未来数据中心转型的动力。

以技术创新和场景创新力广受认可的锐捷网络,不仅提前在CPO路线上进行了技术投入和创新研究,推出首款应用CPO技术的交换机外,还参与编写了COBO最新的CPO交换机设计白皮书,以促进整个产业链上技术的发展和普及。