事件:装载大模型的手机持续增加,例如谷歌/华为(小艺接入盘古)/荣耀(预计自研大模型)/小米/Oppo(AndersGPT))/Vivo(蓝心大模型)/三星(Gauss自研大模型)。1)AIPC拉动的消费电子出现了较多证据。例如AI大模型功能的手机、AI应用提升手机、手机AI芯片在更新。2)据新浪科技,Vivo 11月1日发布蓝心大模型矩阵,共5款自研大模型(从蓝心大模型1B到175B)。此前,Oppo发布AndersGPT(包含10亿、70亿、千亿量级),荣耀预计将在荣耀Magic 6搭载荣耀自研70亿参数大模型,华为小艺已接入盘古大模型。海外,三星于11月8日发布Gauss自研大模型,目前仅内部使用,未来将扩展至三星智能手机端,提升用户体验。

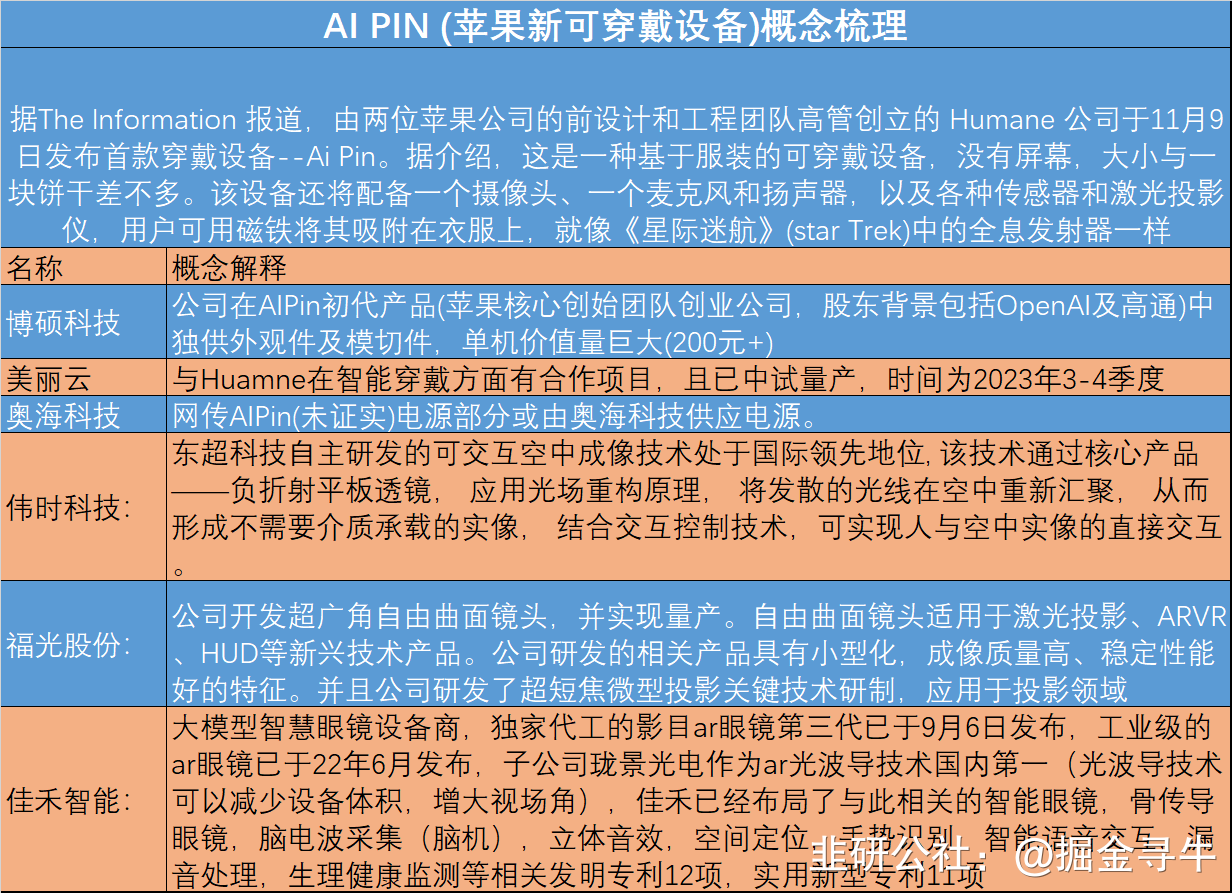

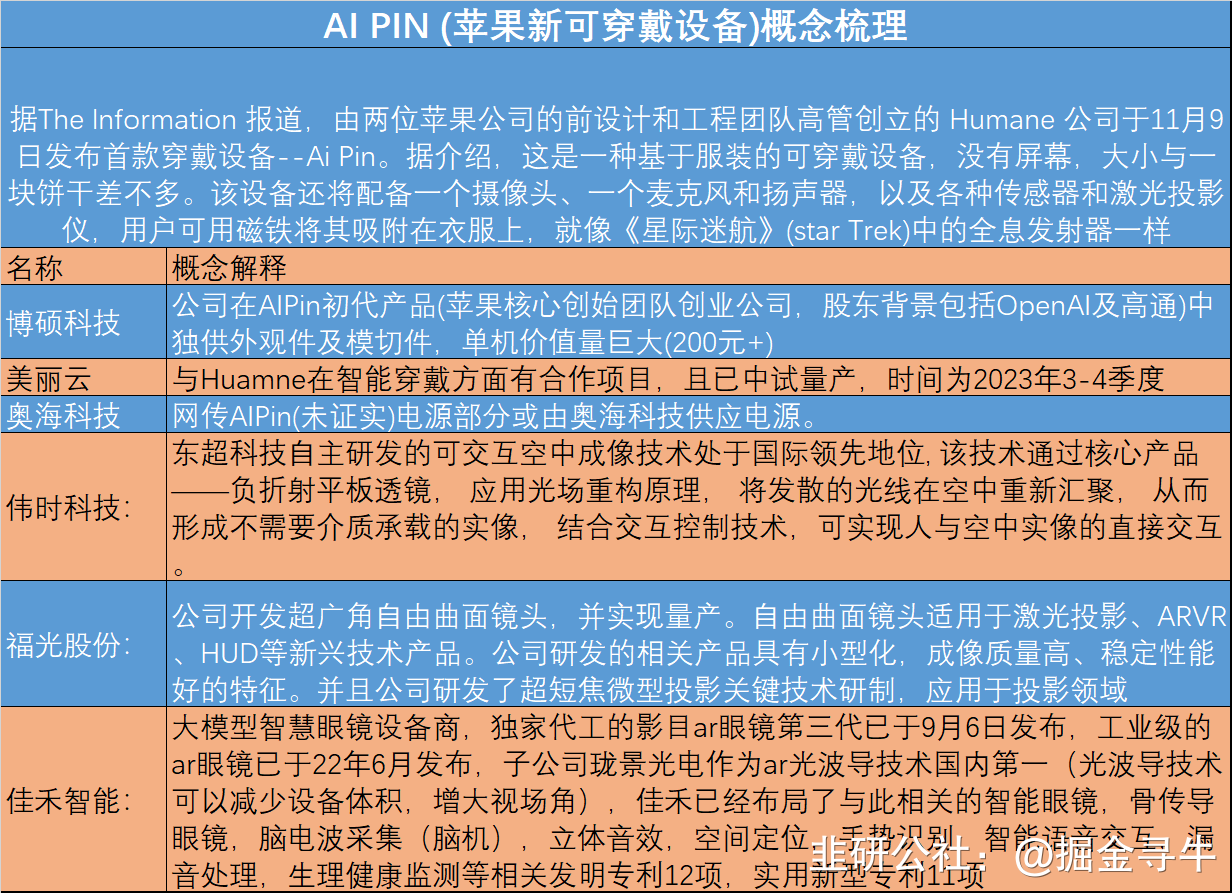

本周,AI Pin(Humane)与GPTs成为重磅新兴事物,它们是AIPC趋势的较大加强。1)其中,AI Pin与AIPC趋势一致,即AI技术在各种终端的下沉,本次是AI下沉到可穿戴设备,要点为软硬件+投影+电池。2)本周Open AI dev day。发布GPT 4 Turbo,增强长期记忆能力,降低成本;提供了新的Agent Platform,可以理解成 Agent 的 App Store。GPTs商店发布一周后,反响热烈,目前自定义GPTs数量已经接近4000个。尽管,GPTs和GPT4 turbo仍存在不足,但预计后续AI大模型的浅层应用会受冲击。Q:与传统PC相比,AI PC处理器会发生什么改变?A:英特尔展示了今年12月14号将要发布的移动端PC处理器 Meteor lake,英特尔将NPU集成到CPU中,Chiplet架构会封装4个Tile进去,包括CPU(用来计算),里面分为能耗核心和性能核心;在SOC里处理显示、声音、媒体、安全、电源管理、内存等,另外我们把NPU单元集成到SOC,主要用来做端侧大模型推理,同时在SOC中集成超低功耗的E core,(在CPU带里集成的是标准的P core和E core)。在未来如果一个指令进到CPU,我们会根据指令分成三个级别:对算力有最低要求的我们会通过超低功耗的E core处理,对算力有中等要求的指令通过E core扩处理,有高级要求的用P core处理,达到节电和长续航的目的。AI PC能力的增强会在SOC里体现,同时把显卡集成在GPU Tile里。IOE Tile集成CPU对外通信的模块,综上架构上的变化是CPU中集成了4个Tile(其中有一个Tile内置NPU),从这一代开始加入NPU用来做人工智能端侧推理。Q:除了CPU加入NPU模块,其他硬件比如存储或者整机架构设计有没有其他变化?A:CPU换代很多技术更新包括WiFi7、蓝牙5.4标准和新的雷电口,包括PCIe5.0,大家去年、前年更换的笔记本大部分是8/16G内存+512G/1T存储算比较高端的设置,但今年双十一,16G内存+1T硬盘成为标准配置。未来中高端笔记本为了适应更大型应用、游戏包括端侧一线的AI PC模型安装,未来中高端笔记本会上升到32G内存+2T硬盘的配置,这也是目前我们和很多ODM厂家聊下来,AI PC的推广带来的比较大的周边促进。Q:相较于传统PC,AI PC会有哪些应用上的变化?现在Windows自带的AI能力是否会替代AI PC的部分功能?A:AI PC 这一代的Meteor lake处理器(5/7/9)都会内置NPU的产品,未来购买这个系列的笔记本都可以被称为AI ready的PC,是具备硬件能力了,但是不能独立应用AI,需要上层模型开发厂商和应用软件厂商支持。未来AI PC有两种应用:离线和在线。离线状态需要我们在笔记本上安装某一个大模型应用厂商训练好且压缩好的、能够安装在端侧的版本,同时PC本地还要安装一些模型需要运行的环境包括向量数据库,都需要安装在PC本地,之后才能才AI PC上使用各种类型的模型推理。相较于传统PC,AI PC一定会带来一些功能丰富,且为以前必须联网或未体验过的应用场景,我们在首发时和国外的合作伙伴做了很多调优和测试包括集成,因为每一个大模型训练的程度不同,我们要告诉这些开发厂商我们的CPU/NPU/GPU都适用于什么样的场景,模型哪些输出需要调用处理器的哪些core来做。我们第一批合作客户包括微软Windows copilot、office copilot、teams,以及zoom、meta,还有国外一家做直播视频的公司xsplit(他们是直播中动态生成数字直播间,同时动态优化背景)、Adobe(其自己有云端大模型,我们也在和他们做一些大模型的尝试看有没有可能拿到本地使用)。还有一家厂商叫jimp,相当于做开源版本photoshop,目前我们已经完成这个修图软件的本地化,我们已经完全在离线端侧实现本地智能修图或者模仿所有基于AI PC的photoshop的功能。 在AI PC推出后,更多看这些AI PC和大模型的厂商是只准备做在线应用体验还是会做离线端侧版本,不管哪种我们都会帮他们做开发、调优和测试。因为微软的office Copilot在国内无法落地,所以我们只说国外市场:因为要收单独的月使用费,目前Windows全家桶没考虑做离线版本,但即使目前只考虑做在线版本,Windows它也做过对比和测试,他拿了Intel 12/13/14不同CPU的PC,去做功能的优化和测试,结果发现他的很多功能在12/13代酷睿笔记本上也可以运行,但是如果在14代上运行会有更好的效果。比如在teams开会,如果用具备AI PC 能力的CUP,会获得更好的背景声音的优化包括降噪、会议室的优化等。Windows现在越做越炫酷,视觉包会越来越大,这一代有一个Windows studio功能,是基于Meteor的CPU做了非常多的优化,包括智能背景变化、智能抠图、眼球追踪、超清分辨率功能,都是与Meteor联合开发了很久才发布的。我们Meteor批量上市会在1/2月份,明年618相关型号会出得差不多了。Q:硬件层面AI PC搭载的NPU是哪些厂商提供的?硬件方面合作客户?AI PC定价和销量预期?A:NPU是英特尔自己的,英特尔在几年前收购了一家以色列的公司,这家公司主要是做视觉计算、视觉图像、人工智能处理芯片相关的公司,这公司以前产品以单独硬件形式呈现比如插在USB上类似U盘的一个东西(视觉计算棒),把这个插到笔记本上,笔记本就会具有一定推理和计算的能力,但是这种使用场景不方便,而且和CPU系统和资源调度集成的并不好,所以我们会把这个软件IP直接封装到Meteor lake的Tile这里面去。英特尔只能规定CPU的价格,终端PC价格是品牌厂决定的,但是客观讲这代CPU会涨价,有两个原因。第一个原因是这一代的CPU是所有产品里第一个采用7nm技术的产品,所以第一批流片研发费用很高;另一个原因是CPU会集成更多功能,这一代英特尔改了命名规格,叫英特尔(ultra)5/7/9,且现在PC市场还没复苏,担心定价过高失去中低端市场,我们会延续上一代Raptor系列会出一类Raptor Lake Refresh,类似于13.5代酷睿覆盖中低端,高端用Meteor lake去打市场,两代并存覆盖整个价位段的PC市场,避免不太好的市场碰到价格高的PC。甚至明年上半年可能会有13/13.5/14代三种机型。成交价方面,价格会有20-50美金的上涨,但是各个厂商会不一样,每个厂家选择的型号和采购量也不同,厂家最终成交价是个机密。 Q:X86架构和ARM架构在做AI端侧芯片时候的优劣势?A:如果是传统的X86架构,用CPU不管去跑人工智能的训练和推理都是非常低效的,这也是NV为什么崛起,因为GPU所有电路逻辑设计是专门去跑跟训练推理或者高性能计算相关的指令级,不会去跑别的事。而X86是一个大而全的东西,什么都能干,但是干什么都不是最好,所以英特尔也看到这个问题,因为13代去跟NPU相关的或者跟人工智能推理相关的负载,都需要外插设备的,或者我直接把相关功能甩给一张外插的显卡。但到了这一代,英特尔发现不能这么干了,因为如果一直做外插CPU,那等于把市场拱手让给了别人,而且现在显卡有禁运风险。英特尔最大的决定就是要把X86和基于NPU的架构集中在同一个CPU封装里面,所以虽然整个CPU是X86架构,但是NPU这个模块是专门为了端侧中低负载的人工智能推理去设计的。在PC领域或者在IT领域里面,从来不是技术最领先的厂家或者技术最领先的产品获得最终的市场胜利,而是要看整个市场生态和合作伙伴支持的情况。高通这几年其实一直有PC端的CPU产品,但是一直没有做起来,原因是相比于英特尔和AMD的竞争,英特尔和AMD是同架构的竞争,但是高通和AMD+Intel就是一个异构的竞争,所以如果高通进来的话那英特尔和AMD会暂时联手先把它干掉,所以这两三年的市场上,其实高通一直在做PC的CPU,但是很难见到一款基于高通CPU的笔记本产品,我自己用过的、见过的,就是华为出过的一款产品,就是类似于Pad一样的小笔记本,但是它那一代产品对Windows的支持包括软件生态也有一定问题,所以就没有做起来。高通重返PC市场,带来一款很新的产品,而且目前看起来算力应该还不低,并且已经获得了微软的支持和认可,但是它能不能获得所有品牌厂商的支持是一个很大的问题。从全球市场来看,DHL三大家明年或者后年会有多少款机型基于高通的设计去做从根本上决定了这款CPU的命运。比如说联想现在是全球PC第一大厂家,占了很大的市场份额,联想可能每一代产品有200款机型在市场上,但是给高通出5/50/150款,侧面决定了高通的市场命运,虽然可以说高通在食物链的顶端,但是这个市场更多把持在ODM厂商的手里。所以高通明年或者现在正在做或者最终要做的,一方面是宣传自己CPU算力很强,另一方面更重要的是跟各个品牌厂商谈,Design in才是最重要的。这个ODM厂商比如说华为、惠普、联想、宏基,它出100款产品里面有多少款是基于英特尔架构的,有多少是基于AMD架构的,有多少款是双架构的,有多少款是英特尔独占的,这些其实才是它未来CPU命运的根本。 Q:异构是把CPU和NPU封到一起了吗?这个不是SOC而是Chiplet对吗A:首先CPU的设计是Chiplet架构,CPU的设计从外面看是一个大的、完整的CPU的片子,但是从里面拆开看其实是四个小片子封装同一个硅基板上,这四个小片子就是我刚才讲的CPU tile、SOC tile、GPU tile和 IOE tie,有一个tile就叫SOC,这个里面会有很多子系统,其中NPU就在SOC那个tile上面,这四个tile会在一起用英特尔的3D封装。以前英特尔上一代产品都是用2.5D封装,我们这一代会用3D封装,基本上现在除了英特尔有3D封装之外,另一个有3D封装的就是台积电cowos,这两家基本是对等的或者同一个级别的技术,我们用3D封装的技术去把四个小的芯片封装在同一个硅基板上,然后把它再封装成一颗大的CPU。因为如果用2.5D需要更大面积,2.5D和3D的基本概念是一样的,只不过2.5D从硅基板到上面每一个小的tile之间会有很多硅通孔,2.5D的时候那个TSV只用来导电不传输数据的,数据还需要横向流动。3D封装的TSV既通电又传数据,这样就提高了数据传输的效率,多了0.5D简单理解就是数据可以底下往上竖着走。Q:做AI边缘端的CPU内存这一块怎么解决?X86的内存是DDR的结构,但ARM是LPDDR6,X86这样在数据延迟上与ARM有比较大的性能差距吗?A:CPU里面是有四个tile,CPU这个tile主要是算力,SOC这个tile里面最重要的除了NPU之外,就是内存的controller和fabric,这个跟NPU在同一个tile上的,这一代支持的也是LPDDR5,下一代是6。 Q:AI PC出来对于国内的哪个环节、哪些公司比较受益呢?A:首先受益是分两方面,如果以前比如说第13代、第12代、第11代的时候受益的只有一类客户,就是跟笔记本硬件生态相关的客户,比如说做Wi-Fi、声卡、屏幕、键盘、电源模块、内存的或者国内SLD厂商,这些肯定都会受益的, Meteor lake出来之后这些厂商也会受益,但是会增加一类厂商就是国内的大模型开发商。他们受益的大前提是所有国外大模型都进不来,我个人认为未来一到两年之内端侧AI PC应用最杀手级应用就是office Copilot全家桶,但是office Copilot进不来,其它不管是ChatGPT还是其他都不能以合法身份进来,其实这是给国内大模型厂商留下了一个巨量的市场空间,因为我个人感觉国内大模型市场是有极大的水分在的,有上百家大模型在跑,但是在一个没有外部垄断的软件厂商竞争的时候,这些厂商是有足够的空间去厮杀、去自我优化、自我打磨产品,而且这一代PC不光具备联网状态下的AI能力,同时还具备离线状态下的能力。国内厂商如果真的比较想在这一块做深,,我觉得他们有一个很好的机会能够抓住时机,真正推出几款在PC端侧上能够杀手级的应用。这两天我跟别的厂家访谈或者跟别的合作伙伴聊,我一直认为office Copilot做这么好,那WPS为什么不能做呢?WPS如果出一个Copilot,就算创新不多,拿office Copilot仿照它做70%、80%的功能出来,也一定会有很多不得不用WPS的打工人会非常喜闻乐见。我觉得受益方一个是传统的笔记本硬件生态链上的那些厂家,再一个就是应用软件的厂家,因为这一次的Meteor lake的发布,是第一次和一个数据中心侧、云端侧的热点赶到一起,以前大家都认为这两侧没有什么关系。这对国内大模型开发厂商是一个很好的机会,比如说百度、腾讯,如果他们把他们的大模型打磨之后,如果能和打工人日常办公所必需的生产力工具结合,一定会有人愿意去买单的。A:法务部已经沟通过了,英特尔现在在卖的数据中心的CPU,未来要出的数据中心的CPU,包括现在在卖的PC端的CPU以及未来要出的PC端的CPU都不会在禁运名单上,因为从算力上讲都还达不到,规定中更多是限制算力,主要是16位浮点、32位浮点的运算能力,这个运算能力是GPU卡擅长的,CPU并不擅长,所以算力其实卡不到CPU的头上。英特尔GPU产品虽然在市场上并没有什么声音,但是其实英特尔的GPU产品大部分都被禁运卡住了,CPU没有被卡住。 Q:如果后面这一块有风险,可能还是要用国产化的,这一块国内有哪些好的公司?A:未来禁运是否会升级、从GPU扩展到CPU,这个不好说,但是我感觉不会,因为这毕竟是一个民用的产品。但是这个东西彻底被停掉了,可能就是现在信创PC的那些玩家,比如说鲲鹏、海光,因为海光现在也开始做端侧的东西如台式机、笔记本,还有飞腾这几家。但是从性能方面讲,个人感觉除了海光之外(因为海光其实是X86天生的兼容者),另外我认为从性能和软件生态的健全性来讲,那可能就是华为的鲲鹏系列,我认为从替代角度,或者从纯技术性能来讲,可能海光和鲲鹏在替代产品里面算第一梯队。Q:国外的很多东西可能暂时进不来,如果明年这些PC发布的话,那我们国内的消费者买这个有必要吗?A:国外那些大模型进不来,但是现在国内大模型其实也不少,我之前个人一直用ChatGPT比较多一些,但是最近也用了百度的文心一言。其实从纯问答式的体验来讲,我觉得文心一言不比免费版的Chat GPT要差,因为免费版的Chat GPT有一个致命的硬伤,因为它的数据是锁死在某一个时间点之前,不是实时更新的,百度文心一言的好处是数据是实时的。所以我认为国内虽说大模型厂商有点过多了,但是我觉得经过一段时间的市场沉淀,包括海量用户去试用,帮助它优化数据集,做提示、训练,国内的大模型在某些应用领域其实可以追上来的。我认为这个软件上的差距不是鸿沟,比一个芯片制造技术好弥补的多。A:对,我觉得未来有一种可能,就是国内的PC厂商比如联想、华为、小米,它们会选择出厂预装自己的大模型,这个是有可能的。包括联想前一段时间也开了发布会,会在明年某些时候推出他们基于PC端的称为AI Twin东西。国内小米本身的技术实力也不弱,华为也是,可能都会有自己的布局,即使自己不出,也会和国内大的厂商进行合作。Q:我们现在看到一些像这种偏软件或者模型研发公司已经在适配新一代架构,目前跟咱们这边有一些接洽吗?A:比如像爱奇艺前两天宣布跟联想、英特尔三方联手,去优化爱奇艺在联想PC上的应用体验,就跟AI相关。国外是比较多的,我觉得国内大模型厂商目前的阶段还是在千军万马挤独木桥的阶段,大家还没有竞争出来一个真正的像Open AI比较具有市场统治地位的厂商。比如要说到文本类的,可能第一反应就是ChatGPT;作图类的比如就是stable diffusion。但在国内不同AI PC赛道上,还不能一下说出来那么一两家代表型企业,所以我觉得国内大模型还在一个大浪淘沙的阶段,就我目前个人的认知来讲,我觉得百度目前来讲是走得最靠前的,比腾讯和阿里包括字节都要靠前。但是百度不像腾讯,比如腾讯有腾讯会议,字节有飞书,这些载体APP是更容易让AI PC去落地的应用,但是百度这个应用又相对比较欠缺。所以百度现在只能拼命把它基于自己的飞桨系统把文心一言做好,让大家去认可它,我认为未来百度可能会走B端市场,去跟其它暂时没有或者不考虑自研大模型的B端软件去合作。在国外基本也是这个路子,比如说全球第三大软件厂商Salesforce,它所有的AI模型能力也不是自研的,都是跟OpenAI合作的。这是中美软件企业的一大差异,美国企业可能更多是说做好我的软件就可以了,如果你有能力,我跟你合作。但是国内的软件厂商可能之前吃过太多大厂的亏,这种新兴应用全愿意自己做,不愿意和大厂或者主流厂商合作,其实这种方式可能会一定程度拖慢AI PC应用上市的时间。Q:AI PC和普通PC相比,比如说用WPS大模型包括文心一言现在在电脑上都可以用,一定用AI PC来用吗?它们是怎么结合的?能举个例子或者说明一下吗?A:举一个例子,可能在国内用离线的模型比较少,就举一个国外的例子。比如说Intel在发布会上展示的那个PC是完全断网的状态下,在PC本地去用训练好的模型,用它的推理功能生成一种模仿某一个流行歌手的歌曲,模仿谁这个是现场输入的,这是完全现场离线生成的。这个东西怎么实现的呢?首先开发商要把它在数据中心训练好的一个模型(可能是几十亿参数、几百亿参数的模型)进行压缩和蒸馏,这两个动作做完之后,这个被训练好的模型就可以压缩到一个本地PC可安装的大小了,可能是几十G或者几百G的小模型安装在PC本地,同时再安装一些去运行推理的相关环境,比如说英特尔的一个AI硬件调度优化环境,包括运行大模型需要一些向量数据库或者其它数据库,安装、训练好了大模型,以及它运行所需要的软件环境,有了这些环境之后,就可以在本地脱机使用这个大模型。使用时背后其实是会调度英特尔里面的GPU、NPU和CPU三种核心,来帮助一起完成这个推理的过程。从输入一个命令比如帮我生成一首模仿谁的歌,按了回车之后,这个大模型会跟英特尔CPU通过Windows操作系统通讯,通讯之后NPU、CPU、GPU会一起工作联合生成这首歌。如果用上一代的产品,比如说13代或者12代的酷睿,它不是不能去生成,但是用14代酷睿,可能用3分钟生成一首歌,用上一代产品可能需要30分钟,用上上一代产品可能需要60分钟,它是一个获得结果的时间与体验的差距,这是作曲的应用。 比如说生成一个文生视频或者文生图应用,它们是高度依赖于本地GPU显卡能力,如果上一代或者上上一代的产品跑应用,那强烈建议你安一个独立显卡,如果没有独立显卡,生成时间会非常慢。但是到了英特尔14代酷睿的时候,首先GPU集成显卡做了增强,同时又可以调度NPU、CPU辅助生成图形或者图象或者视频,会极大提升文生图、文生视频的效率和输出结果。就是用之前那一代不是不能跑,那可能会非常慢,而且效果会很差。Office Copilot也一样, 12代酷睿或者10代酷睿,把Windows升级付费之后一样可以用Office Copilot,但可能它呈现的光影效果不太好。比如我拿一个老笔记本用Teams开会,它获得的背景动态生成、背景渲染这些功能,都会比一台新笔记本体验要差,它不是不能用,只是不好用、体验差或者需要等待的时间长。A:联网的状态下要看怎么用,如果是联网基于一个浏览器架构去访问文心一言,如果是纯浏览器的环境,那体验其实差不多,那样的速度更多取决于网速或者是否买了高级别会员。但是如果是联网状态下用一个安装在笔记本本地的应用,比如说在联网状态下用PowerPoint生成一个PPT大纲或者帮助我做PPT风格的设计,这种情况下在联网的情况下它还是会调本地NPU资源辅助你快速呈现这个结果。Q:在所有PC零部件当中,有没有什么零部件价值量提升了?A:按现在PC配置发展的潮流来讲,未来同样一款PC里面,我认为有增强的除了CPU之外,未来最有可能从硬件的使用量或者容量会有直观提升,那应该是内存和硬盘。其他散热等也有可能升级。Q:明年这些厂商把研发出新的笔记本芯片之后,主流的会提升到什么档次?A:我个人认为32+2T至少覆盖到明年双11应该没有问题,因为32+2T已经是足够用的配置了,即使要在笔记本上装一两个本地大模型的话,其实也够用。Q:华为AI PC的布局或鸿蒙PC的布局?对明年PC行业景气程度的展望?A:明年PC的景气程度,整个PC市场下跌基本是从2022年第二季度开始的。去年年底的时候我们和一些机构在一起展望,展望的结果是在今年2023年第三季度或者第四季度,这个市场有可能触底反弹结束负增长,回到零增长或者回到正增长正比。但是今年已经到11月份了,我们预期中的触底反弹并没有发生,现在第三季度PC销量数据还在同比负增长。目前来讲,大家一致认可的观点就是明年夏天随着6.18到来,PC市场到达拐点并反弹上去。关于AI PC的渗透率,首先是AI PC怎么定义,这一代的处理器全系都支持NPU,理论上来讲你这个笔记本不管是卖3千还是3万、是否跑应用,只要配了这一代的产品,它就可以叫AI ready PC。到时候不管是IDC、英特尔还是其他的市场机构,如果它单独出一个AI PC销量的统计,那一定会把所有产品都统计进去,因为CPU具备这个能力了,它就叫AI PC。但是明年同期我们不光会卖14代,还会卖13.5代的CPU,明年会是两代同时在卖。明年6.18会是Meteor lake的重点推广节点,因为那个时候各个档次的笔记本产品基本都就绪了,基本上13代的库存也出得差不多了,所以明年6.18会是准备大展拳脚的时间点。华为基于英特尔CPU、X86架构的,基于Windows操作系统的PC,华为现在是中国PC市场销量的第二名,第一名是联想,第二名就是华为,包括宏基、戴尔、惠普都排在华为的后面。而且我说的这个PC指的是基于英特尔CPU的Windows操作系统PC,因为信创的PC我们没法儿比,不可能给我们一个准确数据信创PC卖了多少。纯公开的笔记本市场,华为在中国市场排第二。另外轻薄市场PC的销量方面,华为从今年夏天到现在为止一直排第一。所以华为会在Windows+英特尔架构PC之路持续走下去(前提是没有额外的禁令过来),如果华为PC这几年没有受到各种各样的限制,它的销量要远比现在高得多。Q:AI PC它是可以在线的,我们在端侧放这些算力或者存储有什么必要性?A:英特尔9月份那个发布会,推出Meteor Lake这个产品,同时提出AI PC这个概念。Intel对AI PC在端侧的PC理解方面实际上就是两个单词,一个是suspend AI延续AI,延续用户在联网状态下在云端使用AI的使用体验。比如说在上飞机之前,我一直在联网状态下用它的在线联网大模型修图或者生成设计作品,上飞机后如果有三、四个小时时间不能联网,但是我又不想浪费这三、四个小时的时间,如果它推出了一个离线版本,您又购买了这个离线版本且安装在PC上,那在飞机上这个断网的下可以在本地继续用推理功能生成视频和图片继续完成工作,下飞机之后又恢复联网状态再去验证刚才在本地做的工作,把这些工作上传上去,再接着去做创作。这就是在有没有网络情况下,都可以延续AI PC体验,让AI PC体验不间断。 再一个就是英特尔的AI PC还有另外一个词叫Offload AI,就是卸载AI。把一些原来必须要在云端联网状态下去使用的AI PC相关体验,本地就能实现。比如说现在最常用的文生图或者问答类的,但是其实很多非实时类问答类的答案不需要联网,比如我就问它美国的首都在哪儿,这个问题其实完全不需要联网,经过训练的模型装在本地一定知道答案,所以对于这种常识类的,或者基于本地提示就能够完成图片、视频推理结果呈现的应用,是完全把它卸载到本地来,这样在不联网状态下,用户也能够继续使用相关功能工作、休闲。再一个它能够极大减轻用户网络带宽占用需要,以及能够极大减轻大模型运行者的算力占用。其实英特尔的AI PC目标就两个:延续用户的在云端AI体验,以及卸载一些不必要实时联网的AI体验。其实需要软件厂商和英特尔或者和用户一起找到一款杀手级的应用,让大家觉得如果我要用这个应用,联网和不联网都要用。比如说Office Copilot这个功能,如果国内能用的话,我一定会是愿意付费,如果有离线版,我愿意付离线版的费用,因为很多时候我在飞机、火车上就是在写PPT或者文档。还看这个应用够不够杀手级,或者这个应用够不够和大家的日常办公生活强相关。比如说一个做视频编辑或者做图片设计的人,他一定希望随时随地都可以用各种AI帮助他能够在各个场景下工作。Q:如果有些东西需要高频使用的话,还是用自己CPU运行好一些吗?(在网上调用需要付费但只调用自己的就会便宜)A:对,而且更方便。因为国内不管是4G还是5G PC一直没有完全普及开。PC在室外环境下联网,连公共Wi-Fi速率一定是不好的,个人隐私也会有一些问题。但是连手机热点对手机耗电量是一个很大的损伤,因为国内一直没有推广开在笔记本上插一个ESIM卡直接联网,其实有这样的产品,但是市场度一直不高。 Q:AI PC目标用户的特别之处或者特点?是不是只有更多专业用户才有AI PC更换的需求?普通个人基本用不上AI PC吗?Q:我认为作为个人消费者,愿不愿意因为AI PC相关额外功能,或者因为离线大模型的功能去换机,要看AI PC端侧功能对他是否有帮助。比如说我是一个学生最近要做毕业设计需要查阅非常多的文献,写非常多的论文,需要AI PC帮助我总结、归纳很多文章的论点、观点,其实我在那一刻或者那一个时间段需要这个功能;或者我是一个打工者需要天天跟PowerPoint、Word相关,那肯定需要一个端侧AI PC功能。我觉得这个功能跟我的日常工作、学习、生活的相关度越高,我越愿意为这个功能买单,或者愿意为了这个功能换笔记本。我觉得在AI PC推出之后,有足够多的生产力类的端侧大模型能够推出来,会有人愿意付费,因为英特尔14代产品从中低端型号(从5系到7系到9系),而且一个基于英特尔5系的笔记本也就卖4/5千块钱,其实它比一台手机便宜多了,价格的角度不是很大问题。我的看法还是杀手级的应用或者端侧大模型会去推动大家换机。