近日全球领先的科技公司英伟达在2023年全球超算大会(SC23)上推出了一款最新的AI

芯片H200,用于AI大模型的训练,相比于其前一代产品H100,H200的性能提升了约60%到

90%。

其官网毫不掩饰地宣称:“世界最强GPU,专为AI和超算打造”。这款芯片的发布,无疑将为

AI和超算领域带来巨大的变革。

并且 H200与H100完全兼容, 使用H100训练/推理模型的企业,可以无缝更换成最新的

H200,这意味着将H200添加到已有系统中不需要做任何调整。

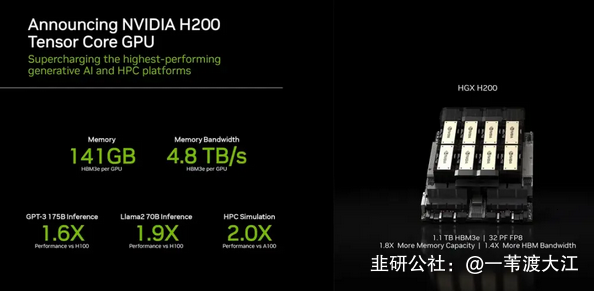

同样基于Hopper架构,配备英伟达H200 Tensor Core GPU和先进的显存,因此可以为生

成式AI和高性能计算工作负载处理海量数据。

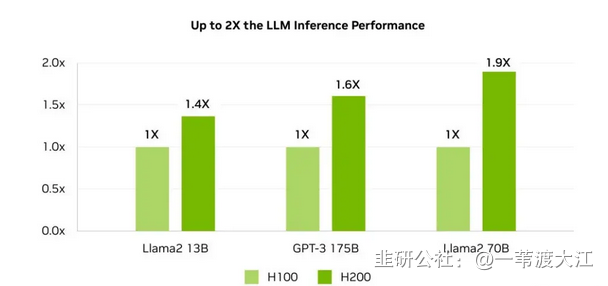

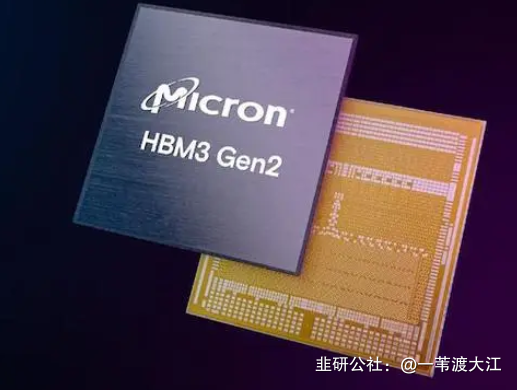

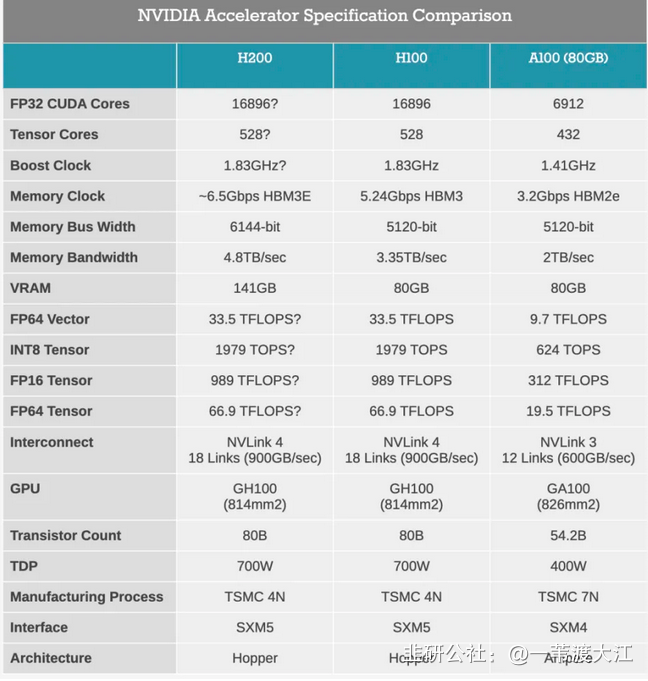

英伟达H200是首款采用HBM3e的GPU,拥有高达141GB的显存,内存带宽也从3.35TB/s提

升至4.8TB/s,提升43%,在HBM3e加持下,H200让Llama-70B推理性能几乎翻倍,运行

GPT3-175B也能提高60%。

除内存大升级之外,H200与同属Hopper架构的H100相比其他方面基本一致。台积电4nm

工艺,800亿晶体管,NVLink 4每秒900GB的高速互联,都被完整继承下来。甚至峰值算力

也保持不变,数据一眼看过去,还是熟悉的FP64 Vector 33.5TFlops、FP64 Tensor

66.9TFlops。

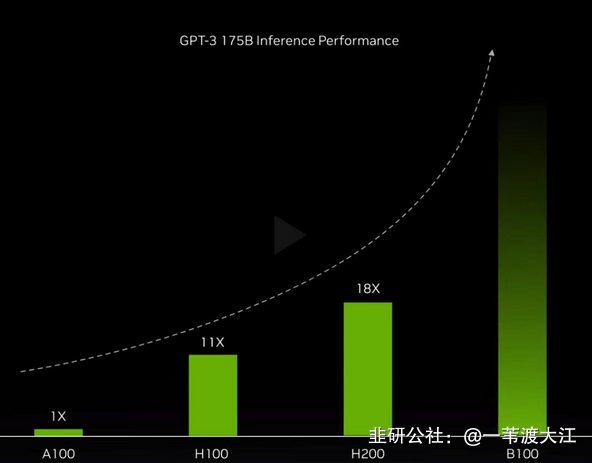

并且2024年的第4季度,基于下一代Blackwell架构的B100也将问世,具体性能还未知,下

图供参考。

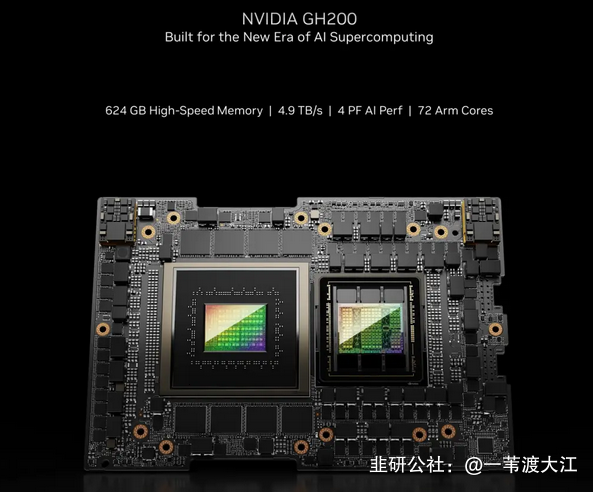

除了H200芯片本身,英伟达此次还发布了由其组成的一系列集群产品。首先是HGX

H200平台,它是将8块H200搭载到HGX载板上,总显存达到了1.1TB,8位浮点运算速度超

过32P(10^15) FLOPS,与H100数据一致。HGX使用了英伟达的NVLink和NVSwitch高速互

联技术,可以以最高性能运行各种应用负载,包括175B大模型的训练和推理。HGX板的独

立性质使其能够插入合适的主机系统,从而允许使用者定制其高端服务器的非GPU部分。

具体到训练大模型方面有何提升呢?英伟达进行了官方测试,相比 H100 ,Llama

2的推理速度几乎翻倍!当用H200与英伟达GraceCPU搭配使用时,就能组成性能

更强的GH200 Grace Hopper超级芯片,专为应用于大型HPC和AI应用!

A股上市公司铂科新材在互动平台表示,公司芯片电感已批量用于英伟达AI芯片GPU-H100;此外HBM封装材料方面建议关注联瑞新材、壹石通、华海诚科等。

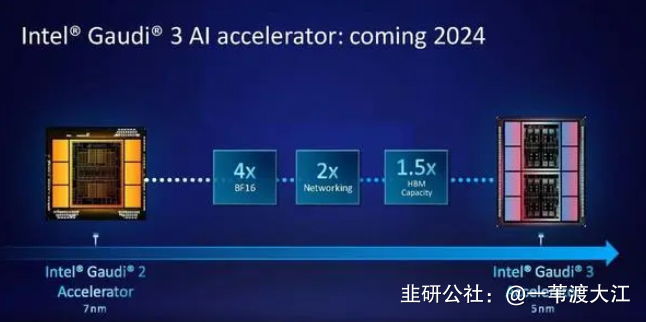

面对英伟达的出招,AMD也即将推出它的大杀器——Instinct MI300X,MI300X将配备

192GB的HBM3和5.2TB/s的显存带宽,这将使其在容量和带宽上远超H200。而英特尔也摩

拳擦掌,计划提升Gaudi AI芯片的HBM容量,并表示明年推出的第三代Gaudi AI芯片将从上

一代的 96GB HBM2e增加到144GB。

就目前而言英伟达仍垄断超过90%的AI算力市场,而它的老对手们显然不会让其一家独

大。随着更多更强性能产品的推出,这场算力军备竞赛将会持续。

而面对美国对我们的科技封锁与打压,此时此刻只想大声的喊出这一句:遥遥领先,幸

好有你!

- 1